AI淨零/黑水虻結合AI轉化廚餘為資源 羽田打造永續經濟

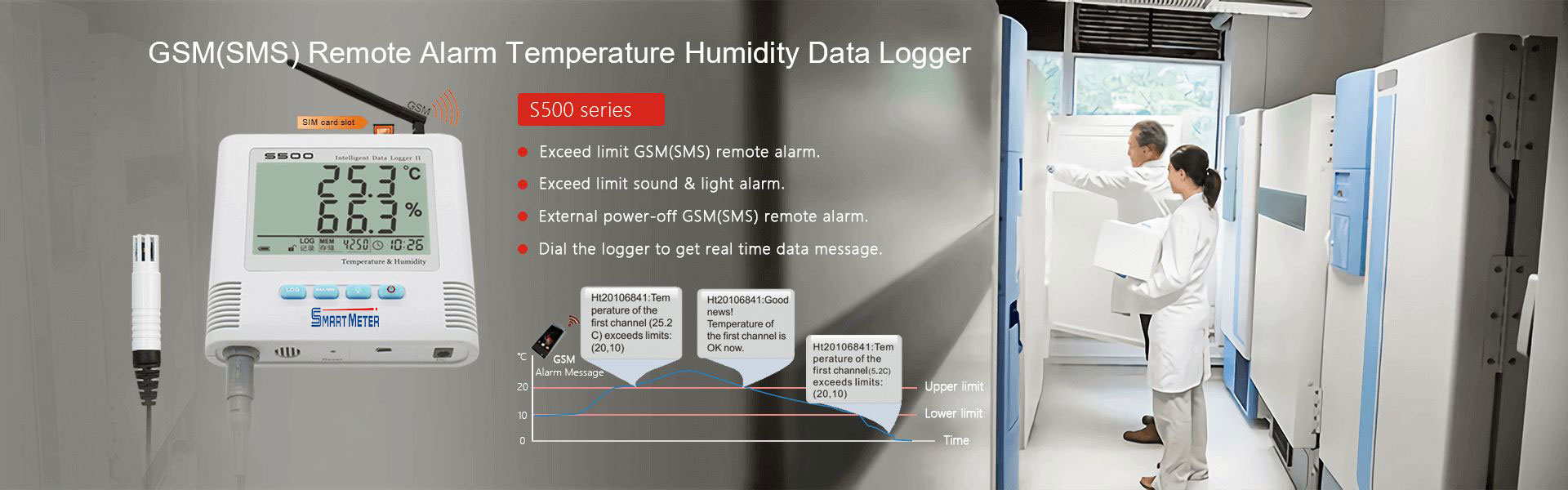

羽田生物農業股份有限公司經理涂智凱(右)表示,黑水虻藉分泌酵素對有機物進行分解為食,蟲糞可作為肥料,被稱為自然界分解者與轉換者。中央社記者鄭維真攝 114年6月30日

羽田生物農業股份有限公司經理涂智凱(右)表示,黑水虻藉分泌酵素對有機物進行分解為食,蟲糞可作為肥料,被稱為自然界分解者與轉換者。中央社記者鄭維真攝 114年6月30日

數位轉型已是產業進行式,人工智慧、淨零碳排更是政府與企業面對的兩大挑戰,攸關台灣未來競爭力。中央社第一線採訪團隊,深入報導政府與百工百業如何運用AI優化生產流程、驅動綠色創新,見證台灣產業再一次躍升。

(中央社記者鄭維真彰化30日電)台灣每年超過62萬噸廚餘,足可堆出超過1萬座台北101大樓,而這些看似無用的剩食,在羽田結合AI(人工智慧)與自然界分解大師黑水虻幫助下搖身變黃金,逐步實現廢棄物零浪費。

「羽田,寓意羽化重生的土壤,我們的使命就是走出一條可持續發展的永續農業之路」,羽田生物農業股份有限公司經理涂智凱語氣堅定地告訴中央社記者。

位於彰化縣的羽田以契作推廣有機農業起家,近年力拚產業升級及轉型,打造從廚餘回收、資源轉換到農牧應用的循環經濟系統,將殘渣、廚餘與污泥等轉化為肥料回歸農民,注入農業永續動能,重新定義廢棄物價值。

在腐敗中重生 黑水虻翻轉農業經濟鏈

羽田目前在員林市、鹿港鎮設有機農產品加工廠及黑水虻養殖廠房,透過契作機制與全台超過150名農民合作,收購山藥、地瓜等有機根莖作物,加工後進連鎖超級市場及賣場銷售。

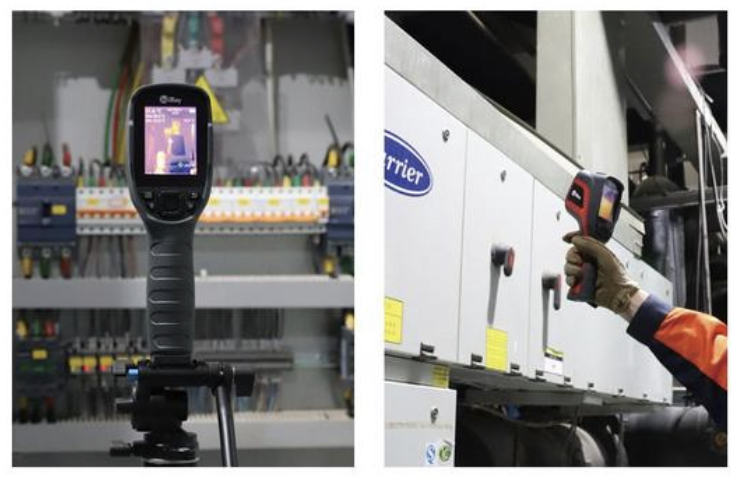

「黑水虻這種專食腐敗物質的昆蟲,是自然界的分解高手與轉換者,能藉由分泌酵素迅速分解有機物,蟲糞成為絕佳肥料來源」,涂智凱表示,以前加工留下的果皮殘渣都要拜託農民幫忙堆肥,羽田花了近2年研究黑水虻養殖設備,進化成自己處理,用黑水虻轉化為肥料。

羽田鹿港廠員工忙著將收回的廚餘破碎脫水,也有人在照料一座座養殖槽。數以萬計黑水虻靜靜待在養殖箱、槽內,專注進食看似不起眼的廚餘。

涂智凱表示,孵育黑水虻須有相當經驗,才能控制孵出最多的量,待養成幼蟲,大概如人類在國中最會吃階段,就可進到養殖槽分解廚餘。

工廠另一頭,涂智凱指著一堆已腐熟的中藥渣,顏色從原本的黃色轉為深褐色,都是黑水虻分解後成果,也就是天然有機肥料。

涂智凱說,羽田和中部許多餐廳配合去化廚餘,黑水虻與傳統廚餘處理方式不同,避開疫病風險,減碳效益至少7成,有的案場距離近,碳排放最多減8成。連食品工廠產出含有機質的污泥,也可經黑水虻轉化成肥料。

「去上游污泥、清下游廚餘」,羽田將農產品殘渣轉化製成的肥料,以便宜價格回售給契作農戶,降低農民肥料成本,種出品質佳、產量高的有機作物。

羽田生物農業股份有限公司利用黑水虻分解廚餘,除蟲糞可當肥料、幼蟲作為飼料,並研發微生物製劑,有利廢水淨化等。中央社記者鄭維真攝 114年6月30日

羽田生物農業股份有限公司利用黑水虻分解廚餘,除蟲糞可當肥料、幼蟲作為飼料,並研發微生物製劑,有利廢水淨化等。中央社記者鄭維真攝 114年6月30日

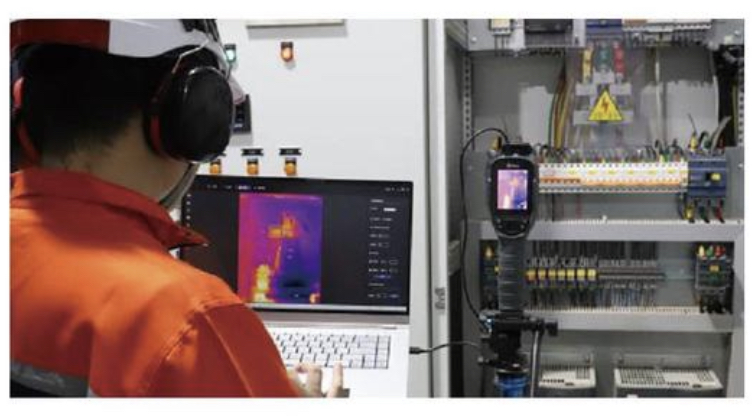

清潔隊最佳幫手 自動化養殖設備革新廚餘處理模式

數年前因應非洲豬瘟防疫契機,羽田念頭一轉,與廚餘回收量最大的新北市政府合作,結合AI研發貨櫃式黑水虻自動化養殖設備,陸續拓展到新竹縣、彰化與台中市等清潔隊,平均每日收40到50噸廚餘。

「一開始處理廚餘時,豬骨、椰子殼讓設備壞了好幾次,繳了不少學費投入研究才克服」,涂智凱回想,初期從北部運廚餘到彰化處理,運費就占總營收4成,為節省運輸成本,發展出可移動式貨櫃,將黑水虻養殖設備移到清潔隊就地處理,每批廚餘最快10到12天就能轉換為肥料。

這設備採層架、密閉設計,有減少異味、不用建廠房、空間利用率增加等優勢,導入AI技術能即時監控溫度與溼度,自動調節排風循環,大幅減碳,提升黑水虻繁殖效率、降低運輸及人力成本,解決地方政府廚餘難題。

涂智凱說,只有將廚餘送進養殖設備及收成需要人力,「傳統貨櫃要3個人負責養殖,3個自動化貨櫃設備只要1人操作電腦就行」。

看準黑水虻潛力 尋求資源再生無限可能

黑水虻糞便能作肥料回歸農業,養大的幼蟲可當飼料回到養殖業,但涂智凱觀察,台灣人工成本高,飼料價格比不過進口,就進一步研發微生物製劑,加入飼料中可改善動物腸胃道菌相,找出另一條路,不怕飼料價格不好。

羽田持續深化應用,混合雞糞與黑水虻蟲糞、微生物製劑後,透過厭氧包裝發酵,經2、3週製成肥料,供給農地使用,避免臭味與蒼蠅滋生等困擾。

涂智凱形容,「微生物製劑就像黑水虻身上小兵,可隨時出擊」,還能輔助養殖戶及食品工廠廢水淨化,減少3到4成污泥產出,節省後端處理成本,而產生的有機性污泥又可運用黑水虻轉為肥料或微生物製劑,不斷循環利用。

透過 Google News

追蹤中央社

放眼未來,涂智凱認為黑水虻潛能遠超想像,「整隻都是寶」,蛹殼可萃取幾丁聚醣,抑制細菌生長,應用於農業、醫藥等產業,黑色素具導電性,吸引半導體產業關注,甚至有韓國業者洽詢收購蟲皮開發機能衣。

他期待羽田跨入更多潛力市場,透過資源轉換與生技等產業鏈連結,實現資源有效利用最大化,打開永續新局。(編輯:李明宗)114063